精選書摘

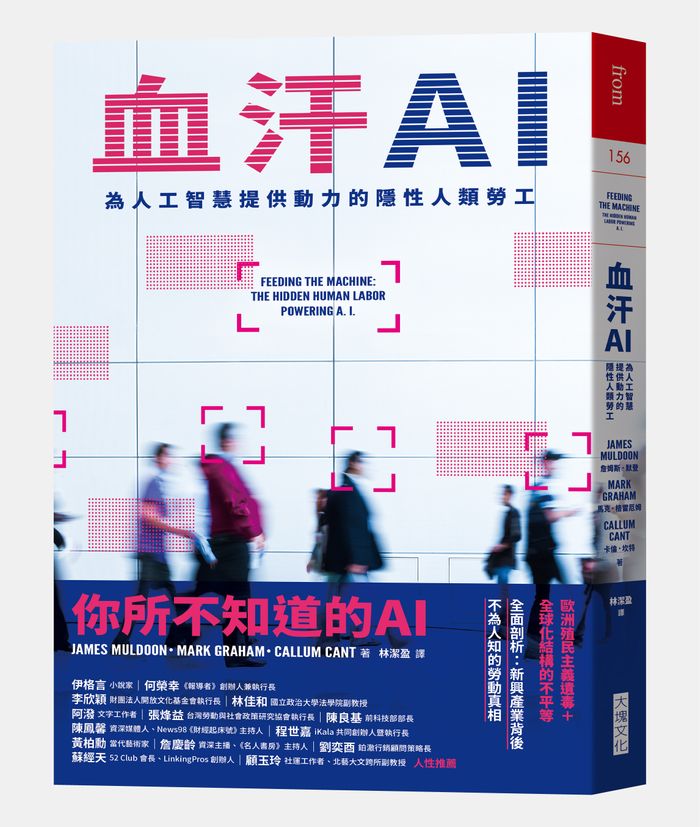

詹姆斯・默登(James Muldoon)、馬克・葛雷厄姆(Mark Graham)與卡倫・坎特(Callum Cant)是「公平工作」(Fairwork)計畫的同事。這個計畫的宗旨是凸顯新興科技在工作場域最理想與最糟糕的使用狀況。在他們完成的《血汗AI:為人工智慧提供動力的隱性人類勞工》書中,揭示了在人工智慧(AI)光鮮亮麗的外表下,隱藏著的殘酷現實:全球數百萬勞動人口往往在惡劣條件下辛勤工作,人工智慧才得以實現。

《血汗AI》書中描繪了刻意被隱藏的工人生活,讓被剝削者表達他們的心聲──包括出色的作家與藝術家,以及許許多多資料標註員、內容審核員與倉庫工人等,書中呈現出他們危險、低薪的勞動,如何與性別、種族與殖民剝削的悠久歷史產生關聯。而對於其他更廣大的職業工作者,作者更直指,人工智慧驅動的工作管理系統來勢洶洶,人工智慧將把權力集中到更少數人手中,並改變工人與老闆之間的關係。

本文為《血汗AI》部分章節書摘,經大塊文化授權刊登,文章標題與內文小標經《報導者》編輯所改寫。

2020年以來,工作場所監控的作法呈爆炸式的成長,許多公司現在都會搜集關於員工工作各個層面的資訊,有時甚至是在員工不知情的狀況下進行。機器學習演算法讓公司分析這些資料並預測未來的行為模式。這些技術在新冠疫情期間大受歡迎,因為各地的管理者都患了「生產力妄想症」,高達85%的管理者擔心遠距工作的員工生產力不足。

在疫情期間,許多雇主強迫員工在家用電腦上安裝各種「老闆軟體」技術,透過各種應用程式與追蹤器監控員工的工作日。自疫情爆發以來,使用此類工具的大型雇主增加了一倍以上。在美國,《紐約時報》(The New York Times)調查發現,十大私人雇主中有80%會追蹤個別員工的生產力。他們往往宣稱工作場所監控技術是為工人維持更安全、和諧工作環境的一種手段。但是,監控與生產力工具滲透到員工生活的各個層面,可能造成一種專橫且讓人窒息的管理控制文化。

在某些辦公室,員工識別證現在可用來追蹤員工進入辦公室的時間與停留時間。其他工作場所則要求遠距員工,在工作日隨時開啟攝影機與麥克風。其他雇主仍然利用監視軟體,幾乎可以記錄一個人在電腦上做的任何事,從他們在特定螢幕上花費的時間,到他們的打字速度,甚至透過網路攝影機祕密監視。根據「數據與社會」(Data & Society)這個美國非營利研究組織的一份報告,即使許多員工意識到自己受監視,卻往往沒有察覺監控的程度,也不知道收集到的資訊要用來做什麼。這份報告所舉的一個例子中,沃爾瑪(Walmart)員工被要求在手機安裝一款應用程式以檢查庫存,但是這個應用程式可以持續存取手機的位置,不斷與公司分享資訊。箇中危險在於,隨著老闆介入員工的私生活,這個軟體會讓監控方式變得愈來愈嚴格。歷史證明,一旦為了應對危機而引進監控措施,這些措施很少會移除。

民間社會組織coworker.org的一份報告指出,在2018年至2021年間,有超過550種科技產品推出,目的是從招募到紀律處分,數位化並監控員工各個層面的生活。在此之前,最先體驗這項技術的是零工,特別是運輸、食品配送與照護等領域;他們工作的每一秒都透過演算法的管理進行量化。許多早期實驗著重於如何協調工人完成任務,而不是監督他們的表現,但也有公司進行自動監控的實驗。眾所周知,優步(Uber)會使用駕駛員的智慧型手機監控他們,例如檢查煞車與加速的習慣,作為安全駕駛的指標。我們現在目睹的是,隨著其他職業被分割成無法再分割的最小單位被降低技術要求,並透過生產力軟體進行監控,這些工具也在勞動力中逐漸擴散。這些工具包括Hubstaff、Time Doctor與FlexiSPY等,其中有80%的軟體鼓勵讓員工長期使用。它們通常結合不斷增加的員工資料與人工智慧的預測能力,以增加對勞動力的管控。

大多數員工都討厭這種形式的監視。一項針對750名科技工作者的調查發現,有一半的人寧願辭職也不願受到老闆的持續監視。有些員工找到了低技術的抵抗方式,例如用模仿人類動作的鼠標移動器來愚弄生產力監控,或是可以破壞電腦上間諜軟體的軟體。然而,並非所有監視技術都能阻止或規避。過去3年來,這類工具當中最具入侵性的,使用率大幅增加:能記錄你輸入的所有內容,包括密碼在內的鍵擊紀錄,增加了40%;允許老闆在員工不知情的狀況下監視的隱形模式,增加了38%;超過三分之一的工具如今可以追蹤員工確切的GPS位置。

風險在於,老闆對提高工作生產力的渴望滲透到員工的私人生活中,員工的個人隱私與身體自主權受到前所未有的侵犯。除了標準的螢幕監控軟體和生產力工具,人工智慧還促成了影集《黑鏡》(Black Mirror)般的新一代技術,比如「心情與情緒分析」、臉部辨識與語音監控軟體。員工監控軟體Teramind是其中最糟的一款,老闆可以藉由控制員工設備的攝影機和麥克風,觀看或偷聽員工在工作場所、甚至家中的對話。更具體地說,一旦發生違規行為,公司可以記錄違規行為前後5分鐘的內容,包括每次鍵擊及完整的錄影。此外,工作場所的穿戴裝置也可記錄員工的健康統計數據,持續監控個別員工,以確保他們能集中注意力且不會壓力過大。

預測式人工智慧工具使用收集到的員工資料為員工進行排名,並為不同的個人提供「風險評分」。人力資源分析工具Perceptyx就是一個例子,它會製作「脆弱性評分」,衡量員工加入工會或離開公司的可能性。 Perceptyx擁有一系列工具,其中包括「感官」(Sense)這款「隨顯式員工監聽產品」。該軟體根據個別員工的語音錄音分析,產生「敬業度指標」評分,並承諾「透過預測建模以減少不必要的人員流動」。人工智慧驅動的文字分析軟體也可以監控員工的電子郵件與Slack (團隊溝通平台)訊息,以評估職場文化與員工對公司的歸屬感。我們很快就可能進入一個局面:每個人的細微臉部表情或語氣變化都會被記錄下來,直接送到人工智慧驅動的評分系統,根據員工的情緒與滿意度評分。

人力資源團隊也廣泛採用人工智慧進行招募與聘用。人工智慧系統可以被運用在招募過程的不同階段,從篩選履歷到建立候選名單、面試、評估性格測驗與評價求職者等。目前,美國有35~45%的公司將人工智慧用於招募人才,此舉讓這些公司在2022節省了40%的招聘成本。人工智慧工具能自動掃描應用程式中的關鍵字與詞組,節省人力資源的時間與金錢。人工智慧也不會專注於求職者的性別、種族或年齡,足以消除人為偏見的因素。然而,其中許多說法都是虛幻的,因為軟體本身已經證明會表現出明顯的偏見,進一步讓求職者的體驗去人性化。

亞馬遜(Amazon)提供了另一個重大案例,警示人工智慧招募的危險性。2014年,蘇格蘭的亞馬遜工程師寫了一個程式,可以自動為求職者評分,向招募人員提供最佳求職者名單。2015年,團隊意識到這個軟體對女性求職者存有偏見,特別是軟體開發人員與工程師等技術職位。這種偏見是因為之前成功申請的求職者資料被用於訓練資料,而這些資料的性別失衡、偏向男性所導致。根據過去的例子,演算法推斷男性求職者更可取,並將包含「女性」字眼(如「女子足球隊」)和畢業於女子學院的應徵者降級。當演算法在履歷中搜尋特定的單字與詞組,它也偏好「執行」與「捕獲」等行動導向的語句,而男性求職者更可能使用這些語詞。在嘗試修正這些偏差未果後,亞馬遜於2018年捨棄了這個計畫。

劍橋大學的研究人員研究了人工智慧在招募過程中消弭各種種族與性別偏見的潛力,發現軟體能達到的效果有非常大的局限性。研究人員提出相當有說服力的說法,表示這類工具揭露了「對種族與性別的普遍誤解」,將種族與性別視為個人的潛在可移除屬性,而非塑造組織與社會運作方式更廣泛的權力系統。正如亞馬遜的案例所示,種族化與性別化的系統會影響個人使用的語言類型、行為模式,以及別人看待他們的方式,即使據稱是中立的演算法,在執行評估時亦是如此。因此,如果演算法只被訓練去看到履歷中提及的性格特質、具體技能與某些關鍵字的普遍性,依然可能產生歧視性的結果。

許多人工智慧系統使用的其中一項指標,是評估求職者的「五大」人格特性(外向性、親和性、開放性、盡責性、情緒不穩定性),以避免任何種族化或性別分類。這些人工智慧公司宣稱,人格分數可以對求職者的能力做中立的評估,比起招募人員對其經驗的主觀評價,這更能任人唯才。然而,即使這樣的人格測驗似乎也無法產生公正的結果。證據顯示,求職者在測驗時的穿著打扮與所操的語言,都可以改變這些工具對求職者性格的部分看法。這些所謂的人格評估近乎偽科學,根據人們的語氣或螢幕上的外觀,建立可靠的「行為特徵」,從而預測工作表現。

公司不僅使用軟體來整理履歷,有些公司會邀請求職者參加自動化視訊面試,要求求職者盯著網路攝影機並回答預先錄製的問題。然後,人工智慧驅動的軟體就會分析他們的回答,以確定他們是否適合這份工作。例如,Modern Hire擁有一個「人工智慧驅動的自動化面試平台」,稱作「自動化面試創造器」(Automated Interview Creator),可以協助人力資源部門發展面試並評估求職者。人工智慧工具主要用來謄寫面試內容,並根據轉錄下來的文字對求職者進行評估與排序。但在此之前,收購了Modern Hire的HireVue是使用臉部辨識人工智慧工具來分析視訊面試,結果被投訴到聯邦貿易委員會(Federal Trade Commission),指稱有不公平和欺騙的行為。該軟體聲稱可以分析求職者的臉部表情、微手勢、語氣和線上狀態,以評估性格特徵與適合程度。雖然HireVue停止使用這類工具,很難估計這些工具在業界的盛行程度。

美國有些州正在制定法律,規範人工智慧在招募中的使用,譬如伊利諾州立法機構的「人工智慧影像面試法」(Artificial Intelligence Video Interview Act),以及紐約州的「自動化聘雇決策工具」(Automated Employment Decision Tool)法規。歐盟人工智慧法案(EU AI Act)也將人工智慧招募軟體歸類為「高風險」,意指公司必須符合一長串要求,以確保軟體的安全性,並在可公開存取的資料庫中,提供有關其系統的資訊。但就目前而言,這項技術的大部分使用仍然取決於雇主,這也為潛在帶有偏見的決策留下了很大的空間。

人工智慧技術在工作場所的部署,有可能推動新形式的監視與管理主導權。工作強化的現象正從工業部門蔓延到零售業、接待業與更廣泛的服務部門。所有這些控制技術在工作場所都具有雙重目的。它們既降低了生產成本(以犧牲工作品質、工人自主性與基本民主權利為代價),也犧牲工人的權益,以賦予老闆權力。

監視技術讓雇主鎮壓員工的反抗,也可能阻礙工人在公司內的組織與代表。老闆除了聘請專門機構提供建議、阻止工人組建工會,也利用工作場所頻道監控工人的對話,或是透過攝影機監視。例如,亞馬遜就被員工指控,稱公司會悄悄監控參與工會活動者的電子郵件名單。工人用許多方法反抗這種技術的部署,從祕密違反規則到離職等。這些反抗形式大都停留在個人,或是和極小的群體共享。5、6個同事可能會討論如何欺騙亞馬遜倉庫的速度計算,為自己贏得一些急需的休息時間,但這類詭計通常在暗中進行。

這是職場上工人與老闆利益衝突的有機副產品。但有時候,當特定條件滿足了,這種非正式的個人抵制會擴大為更持久、更公開的抵抗。

用行動支持報導者

獨立的精神,是自由思想的條件。獨立的媒體,才能守護公共領域,讓自由的討論和真相浮現。

在艱困的媒體環境,《報導者》堅持以非營利組織的模式投入公共領域的調查與深度報導。我們透過讀者的贊助支持來營運,不仰賴商業廣告置入,在獨立自主的前提下,穿梭在各項重要公共議題中。

你的支持能幫助《報導者》持續追蹤國內外新聞事件的真相,邀請你加入 3 種支持方案,和我們一起推動這場媒體小革命。